Looking for?

Naviguer dans les considérations de conformité au titre de la loi sur l'IA pour les dispositifs médicaux pilotés par l'IA

Introduction

L'intégration de l'intelligence artificielle (IA) et des technologies de pointe dans les dispositifs médicaux transforme les soins de santé en permettant des avancées sans précédent dans les diagnostics, la planification des traitements et la gestion des patients. Qu'il s'agisse d'outils d'analyse d'imagerie alimentés par l'IA ou de recommandations thérapeutiques automatisées, ces innovations offrent un immense potentiel d'amélioration des résultats pour les patients et de rationalisation des flux de travail cliniques. Cependant, à mesure que l'utilisation de l'IA dans les dispositifs médicaux continue de se développer, la complexité de l'environnement réglementaire dans lequel les parties prenantes doivent naviguer s'accroît également.

En Europe, la réglementation des logiciels à finalité médicale, y compris les solutions pilotées par l'IA, est régie par les normes rigoureuses énoncées dans le règlement sur les dispositifs médicaux (Medical Device Regulation, MDR)i et le règlement sur les dispositifs médicaux de diagnostic in vitro (In Vitro Diagnostic Medical Devices Regulation, IVDR).ii Ces règlements, pleinement applicables depuis le 26 mai 2021 et le 26 mai 2022 respectivement, établissent des exigences strictes pour l'évaluation et la commercialisation de ces dispositifs au sein de l'Union européenne (UE).

Avec l'adoption récente du règlement sur l'intelligence artificielle (Artificial Intelligence Act, AIA),iii un cadre législatif complet qui s'applique à tous les secteurs de l'industrie, le paysage réglementaire de l'IA est devenu beaucoup plus complexe. En vertu de l'AIA, les systèmes d'IA intégrés dans les dispositifs médicaux réglementés par le MDR et l'IVDR peuvent être classés comme étant à haut risque, ce qui impose des obligations de conformité supplémentaires en vertu de l'AIA.iv Cela crée un double paysage réglementaire, où les parties prenantes doivent naviguer entre les exigences spécifiques à l'IA et les cadres MDR/IVDR établis.

Déterminer avec précision si votre logiciel peut être considéré comme un système d'IA au sens de l'AIA est une étape essentielle pour garantir la conformité et identifier les voies réglementaires appropriées. Des erreurs de classification peuvent conduire à des obligations de conformité non respectées ou, à l'inverse, à des charges réglementaires inutiles. Pour un aperçu complet des éléments fondamentaux de l'AIA, y compris les définitions clés, le champ d'application et les classifications des risques, nous vous invitons à vous référer à notre précédent article de blog sur l'AIA. Ce contexte pose les bases nécessaires à la compréhension des exigences de conformité spécifiques abordées dans cet article de blog.

Cet article de blog a pour but d'offrir des idées pratiques pour se préparer au paysage de la conformité à l'AIA en ce qui concerne les dispositifs médicaux pilotés par l'IA. Nous explorerons les considérations clés pour vous aider à naviguer efficacement dans les exigences de l'AIA, en veillant à ce que vos systèmes d'IA répondent aux normes de conformité, soient prêts pour le marché et s'alignent sur les réglementations en cours d'évolution. Il est important de noter que cette discussion se limite aux systèmes d'IA à l’intersection avec les réglementations MDR et IVDR. Nous ne couvrons pas les exigences de conformité spécifiques au MDR/IVDR et n'examinons pas les obligations relatives à l'IA à usage général (General Purpose AI, GPAI) ou aux composants d'IA générative qui pourraient être superposés aux systèmes d'IA existants. Un examen détaillé de ces aspects nécessiterait des analyses distinctes et ciblées.

Systèmes d'intelligence artificielle et dispositifs médicaux à haut risque

L'AIA classe les systèmes d'IA en quatre catégories fondées sur le risque : risque inacceptable, risque élevé, risque de transparence et risque minimal. Cette approche par paliers vise à garantir que la charge réglementaire est proportionnelle aux risques potentiels posés par le système d'IA. Pour une exploration plus détaillée de ces classifications et de leurs implications, nous vous recommandons de consulter notre précédent article de blog.

Les systèmes d'IA à haut risque représentent la catégorie la plus lourdement réglementée par l'AIA en raison de leur impact potentiel important sur la santé, la sécurité et les droits fondamentaux. L'article 6 de l'AIA définit différents critères pour déterminer le statut de risque élevé en se référant à l'Annexe I et à l'Annexe III. Cette discussion se concentrera spécifiquement sur l'Annexe I, car elle détaille la législation d'harmonisation de l'Union directement pertinente pour la portée de cet article de blog – en particulier les systèmes d'IA qui peuvent être qualifiés de dispositifs médicaux (DM) ou de dispositifs médicaux de diagnostic in vitro (DIV) en vertu du MDR et du IVDR.

Critères relatifs aux systèmes d'IA à haut risque liés à l'Annexe I de l’AIA

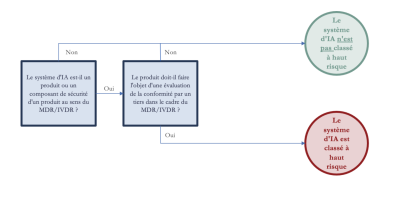

Selon l'article 6(1) de l'AIA, un système d'IA est considéré comme à haut risque si (conditions cumulatives):

(a) il est destiné à être utilisé comme composant de sécurité d'un produit, ou est lui-même un produit, couvert par la législation d'harmonisation de l'Union énumérée à l'Annexe I ; et

(b) le produit doit faire l'objet d'une évaluation de la conformité par un tiers conformément à la législation d'harmonisation de l'Union énumérée à l'Annexe I.

L'organigramme ci-dessous fournit un guide visuel sur la manière dont les systèmes d'IA liés au MDR/IVDR sont évalués en vue d'une classification à haut risque en vertu de l’AIA. Ce processus décisionnel illustre l'application des critères de l'article 6(1) spécifiquement pour les systèmes d'IA intégrés dans les dispositifs médicaux.

Décryptage des critères de risque élevé pour les dispositifs médicaux pilotés par l'IA dans le cadre de l'AIA

Examinons maintenant chaque critère pour comprendre comment ils s'appliquent spécifiquement aux systèmes d'IA dans le cadre du MDR et de l'IVDR, en précisant quand ces systèmes sont classés à haut risque dans le cadre de l’AIA.

(a) Produit ou composant de sécurité :

▪ Le produit lui-même: Le système d'IA peut être le produit médical principal, tel qu'un logiciel d'IA autonome pour les diagnostics, les recommandations thérapeutiques ou le suivi des patients. Il s'agit par exemple d'outils d'analyse d'imagerie pilotés par l'IA ou de logiciels d'aide à la décision clinique.

▪ Composant de sécurité: Le système d'IA peut également être un élément essentiel d'un dispositif médical, dont il améliore la sécurité et les performances. Par exemple, un algorithme d'IA intégré dans un dispositif de surveillance cardiaque qui déclenche des alertes en cas de lectures anormales agit comme un composant de sécurité parce qu'il affecte directement la sécurité du patient en permettant des interventions opportunes.

(b) Exigence d'évaluation de la conformité par un tiers: En plus d'être un produit ou un composant de sécurité, le système d'IA doit également faire l'objet d'une évaluation de la conformité par un organisme notifié, comme l'exige le MDR ou le IVDR, pour être classé à haut risque.v En règle générale, les dispositifs médicaux de classe IIa, IIb et III selon le MDR et de classe B, C et D selon le IVDR sont particulièrement concernés par cette classification en raison des risques inhérents qu'ils présentent pour les patients. Plus la classification est élevée, plus l'impact potentiel sur la santé du patient est important, ce qui nécessite une évaluation et une surveillance plus strictes. Il ressort clairement de ce qui précède que l'AIA adopte une approche ciblée en ne classant dans la catégorie des systèmes à haut risque que les systèmes d'IA qui peuvent être considérés comme un produit ou un composant de sécurité et qui font l'objet d'évaluations de conformité par des tiers. Cette approche garantit que les systèmes d'IA ayant un impact significatif sur la sécurité et les résultats cliniques sont rigoureusement évalués et soumis aux normes de conformité les plus strictes en vertu de l’AIA.

Aperçu des exigences applicables aux fournisseurs de systèmes d'IA à haut risque

Pour les dispositifs médicaux pilotés par l'IA classés comme systèmes d'IA à haut risque en vertu de l'AIA, le respect des exigences relatives aux systèmes d'IA à haut risque énoncées dans l'AIA est essentiel. Si bon nombre de ces obligations s'alignent sur les normes MDR/IVDR existantes – telles que le maintien d'un système de gestion de la qualité, la préparation d'une documentation technique détaillée et la fourniture d'instructions d'utilisation claires – l'AIA introduit des normes supplémentaires adaptées aux complexités des technologies de l'IA. Voici un aperçu de certaines des principales exigences de conformité imposées par l'AIA aux fournisseurs de systèmes d'IA à haut risque:

▪ Connaissance de l'IA (article 4): Les fournisseurs doivent veiller à ce que leur personnel et leurs opérateurs aient des connaissances suffisantes en matière d'IA, compte tenu de leur expérience, de leur formation et du contexte d'utilisation du système d'IA.

▪ Système de gestion des risques (article 9): Les fournisseurs doivent établir, documenter et maintenir un système de gestion des risques continu tout au long du cycle de vie du système. Il s'agit notamment d'identifier, d'analyser et d'atténuer les risques prévisibles pour la santé, la sécurité ou les droits fondamentaux, de procéder à des essais systématiques et de veiller à ce que les risques résiduels soient ramenés à un niveau acceptable grâce à la conception, à des mesures d'atténuation, ainsi qu'à une information et une formation adéquates des utilisateurs.

▪ Données et gouvernance des données (article 10): Les fournisseurs doivent veiller à ce que les ensembles de données d’entrainement, de validation et de test répondent à des normes strictes de qualité et de gouvernance, tiennent compte des biais potentiels et respectent des garanties strictes, y compris les réglementations en matière de protection des données, en particulier lorsqu'ils traitent des catégories particulières de données à caractère personnel.

▪ Documentation technique (article 11): Les fournisseurs doivent établir et tenir à jour la documentation technique des systèmes d'IA à haut risque avant leur mise sur le marché, en veillant à ce qu'elle démontre la conformité aux exigences réglementaires et contienne toutes les informations essentielles à l'évaluation, comme indiqué à l'Annexe IV de l’AIA.

▪ Tenue de registres (article 12): Les fournisseurs doivent veiller à ce que les systèmes d'IA à haut risque disposent d'une journalisation automatisée tout au long de leur cycle de vie, afin d'enregistrer les événements à des fins de traçabilité du système, d'identification des risques et de suivi après la mise sur le marché. Les registres essentiels comprennent les horodatages d'utilisation, les vérifications des données d'entrée ainsi que le personnel impliqué dans la vérification des résultats, le cas échéant.

▪ Transparence et fourniture d'informations au Déployeur (article 13): Les fournisseurs doivent veiller à ce que les systèmes soient conçus dans un souci de transparence, afin de permettre aux déployeurs de comprendre et d'utiliser correctement les résultats du système. Des instructions d'utilisation claires doivent être fournies, couvrant les coordonnées du fournisseur, les capacités du système, les mesures de précision, les risques prévisibles, les mesures de surveillance humaine, les spécifications de performance, les lignes directrices en matière de maintenance et, le cas échéant, les mécanismes de gestion et d'interprétation des journaux.

▪ Surveillance humaine (article 14): Les fournisseurs doivent concevoir des systèmes qui permettent une surveillance humaine efficace afin d'atténuer les risques liés à la santé, à la sécurité ou aux droits fondamentaux. Les mesures de surveillance doivent correspondre au risque, à l'autonomie et au contexte du système, permettant aux utilisateurs de comprendre, de surveiller, d'interpréter et d'intervenir si nécessaire, y compris de neutraliser ou d'arrêter le système. Les systèmes doivent intégrer ou faciliter les outils de contrôle, en veillant à ce que les utilisateurs puissent vérifier les résultats et éviter les biais liés à l'automatisation.

▪ Précision, robustesse et cybersécurité (article 15): Les fournisseurs doivent veiller à ce que les systèmes d'IA à haut risque conservent leur précision, leur robustesse et leur cybersécurité tout au long de leur cycle de vie, y compris leur résistance aux erreurs et aux modifications non autorisées. Ils doivent remédier aux vulnérabilités, telles que l'empoisonnement des données ou des modèles et les attaques adverses, et empêcher les boucles de rétroaction biaisées. Les mesures de précision déclarées devraient être incluses dans les instructions de l'utilisateur, et les solutions techniques doivent s'aligner sur les niveaux de risque et les contextes opérationnels.

▪ Exigences en matière d'étiquetage et d'accessibilité (article 16): Les fournisseurs doivent indiquer leur nom, leurs coordonnées commerciales et leur adresse de contact sur le système d'IA à haut risque, son emballage ou la documentation qui l'accompagne et veiller au respect des exigences en matière d'accessibilité conformément aux directives (UE) 2016/2102 et (UE) 2019/882.

▪ Système de gestion de la qualité (article 17): Les fournisseurs doivent mettre en place un système de gestion de la qualité documenté qui garantit la conformité réglementaire et couvre des domaines tels que la conception, le développement, la gestion des données et l'évaluation des risques, entre autres. Ce système doit également intégrer la surveillance après la mise sur le marché, la notification des incidents et des protocoles de communication clairs avec les autorités compétentes et les parties prenantes. La portée et la mise en oeuvre du système de gestion de la qualité doivent être proportionnelles à la taille de l'organisation du fournisseur et peuvent s'aligner sur les lois sectorielles ou de gouvernance financière existantes, le cas échéant.

▪ Conservation de la documentation (article 18): Les fournisseurs doivent conserver la documentation technique, les enregistrements du système de gestion de la qualité et les autres documents de conformité pertinents pendant au moins dix ans après la mise sur le marché du système d'IA à haut risque. ▪ Conservation des journaux (article 19) : les fournisseurs doivent conserver les journaux générés automatiquement par leurs systèmes d'IA à haut risque pendant au moins six mois ou conformément aux dispositions du droit de l'Union ou du droit national applicable.

▪ Mesures correctives et obligation d'information (article 20): les fournisseurs doivent prendre rapidement des mesures correctives s'ils estiment qu'un système d'IA à haut risque qu'ils ont mis sur le marché n'est pas conforme, notamment en notifiant les parties concernées et, si nécessaire, en retirant ou en rappelant le système. Si le système présente un risque, les fournisseurs doivent en rechercher la cause, collaborer avec les déployeurs le cas échéant, et informer les autorités de surveillance du marché, et le cas échéant l'organisme notifié, de la non-conformité et des mesures correctives prises.

▪ Coopération avec les autorités (article 21): Les fournisseurs doivent fournir aux autorités compétentes, sur demande, tous les documents et informations nécessaires pour prouver la conformité de leurs systèmes d'IA à haut risque, dans une langue officielle de l'UE aisément compréhensible, comme indiqué par l'État membre concerné. Ils doivent également permettre l'accès aux journaux, si pertinents et sous leur contrôle, en préservant la confidentialité conformément à l'article 78.

▪ Désignation d'un représentant autorisé (article 22): les fournisseurs établis en dehors de l'UE doivent désigner un représentant autorisé dans l'Union chargé de vérifier la conformité, de maintenir l'accès à la documentation pour les autorités et d'aider à prendre des mesures réglementaires. En cas de non-conformité, le représentant doit mettre fin à son mandat et en informer les autorités compétentes.

▪ Évaluation de la conformité, déclaration de conformité UE, marquage CE et enregistrement (art. 43, 47, 48 et 49): Avant de mettre un système d'IA sur le marché de l'UE ou de le mettre en service, une évaluation de la conformité doit être effectuée, suivie de l'établissement d'une déclaration de conformité UE et de l'apposition du marquage CE. Le système doit également être enregistré dans la base de données de l'UE. L'AIA permet une évaluation unifiée couvrant à la fois l'AIA et le MDR/IVDR si l'organisme notifié est qualifié pour les deux. Dans le cas contraire, des évaluations distinctes sont nécessaires, ce qui peut entraîner des audits en double et des coûts de mise en conformité plus élevés. Si les mises à jour prévues dans la documentation initiale ne nécessitent pas de réévaluation, les changements importants qui ont une incidence sur la finalité du système ou sur le profil de risque requièrent une nouvelle évaluation. À partir du 1er août 2026, même les systèmes d'IA déjà sur le marché devront se conformer aux exigences de l'AIA s'ils subissent des modifications substantielles.

▪ Surveillance après la mise sur le marché (article 72): Les fournisseurs doivent mettre en place et documenter un système de surveillance consécutif à la mise sur le marché adapté à la nature et au risque du système d'IA, afin de garantir une conformité continue en collectant et en analysant activement les données de performance pertinentes tout au long du cycle de vie du système. Ce système doit être fondé sur un plan de surveillance après commercialisation inclus dans la documentation technique et peut être intégré aux systèmes de surveillance existants prévus par la législation européenne connexe afin d'éviter les doubles emplois et d'assurer la cohérence.

▪ Signalement des incidents graves (article 73): Les fournisseurs doivent signaler rapidement les incidents graves, procéder à des évaluations des risques, prendre des mesures correctives et coopérer aux enquêtes sans modifier le système d'IA avant d'en informer les autorités. Les rapports doivent être établis dans des délais précis, tout en permettant des rapports initiaux incomplets dans un premier temps. Les organismes nationaux et la Commission doivent être informés, et des lignes directrices de mise en conformité sont attendus d'ici août 2025.

Normes pour les systèmes d'IA à haut risque

Si l'AIA définit les exigences applicables aux systèmes d'IA à haut risque, la mise en oeuvre pratique de ces exigences dépend fortement de l'élaboration de normes européennes harmonisées. Ces normes serviront de pierre angulaire au cadre de l'AIA, traduisant ses exigences juridiques en spécifications techniques concrètes pouvant être appliquées dans la pratique. Ces normes sont élaborées par le Comité européen de normalisation (CEN) et le Comité européen de normalisation électrotechnique (CENELEC), à la suite d'une demande formelle de normalisation adoptée par la Commission européenne en mai 2023.vi L'élaboration de ces normes s'inspirera non seulement des normes internationales, telles que celles de l'ISO et de la CEI, mais traitera également des aspects uniques de l'AIA. Contrairement aux efforts internationaux existants, les normes de l'AIA donneront la priorité aux risques pour la santé, la sécurité et les droits fondamentaux, au-delà des seuls objectifs organisationnels.vii Cela inclut des dispositions spécifiques pour la gouvernance des données et des mesures de qualité adaptées pour atténuer ces risques, ainsi que des exigences pour des mécanismes de surveillance qui produisent des résultats vérifiables. Ces normes devraient être finalisées d'ici à la fin avril 2025.viii Une fois publiées au Journal officiel de l'Union européenne, ces normes constitueront une "présomption de conformité", ce qui signifie que les systèmes d'IA qui y adhèrent seront considérés comme conformes aux exigences de l'AIA.ix

Conformité des tiers fournisseurs pour l'intégration et l'utilisation dans les systèmes d'IA à haut risque

L'AIA aborde le rôle des parties impliquées dans la fourniture de systèmes, d'outils, de services, de composants ou de processus d'IA qui sont utilisés ou intégrés dans des systèmes d'IA à haut risque (y compris les systèmes d'IA qui sont classés comme dispositifs médicaux à haut risque), et étend les responsabilités à ces parties.x Ces tiers jouent un rôle essentiel tout au long de la chaîne de valeur de l'IA, en contribuant à la formation, au recyclage, aux essais, à l'évaluation, à l'intégration et à d'autres aspects essentiels du développement des systèmes d'IA.xi

L'article 25(4) prévoit que lorsque ces éléments sont fournis en vue d'être intégrés ou utilisés dans des systèmes d'IA à haut risque, un accord écrit doit être conclu entre le tiers fournisseur des éléments et le fournisseur du système à haut risque.xii Cet accord doit préciser les informations, les capacités, l'accès technique et les autres formes d'assistance nécessaires, conformément à l'état de l'art généralement reconnu, pour permettre au fournisseur de se conformer pleinement aux obligations qui lui incombent en vertu de l’AIA.xiii Un tel accord garantit que le système d'IA à haut risque peut satisfaire aux normes essentielles de fiabilité, de robustesse, d'exactitude et de transparence, comme le prévoit l’AIA. Pour faciliter la mise en oeuvre de ces exigences, le Bureau européen de l'IA (European AI office) peut élaborer et recommander des modèles de clauses contractuelles volontaires qui tiendront également compte des exigences contractuelles propres au secteur ou à l'entreprise. xiv

Pour les outils, services, composants ou processus – à l'exclusion des modèles d'IA à usage général – mis à la disposition du public sous une licence libre et gratuite, les obligations de conformité prévues à l'article 25(4) ne s'appliquent pas.xv Toutefois, l'AIA encourage vivement les développeurs à adopter des pratiques de documentation largement reconnues, telles que les fiches de modèle ou les fiches techniques.xvi Ces pratiques améliorent la transparence, favorisent la collaboration tout au long de la chaîne de valeur de l'IA et garantissent une utilisation ou une intégration responsable dans les systèmes d'IA à haut risque. En fournissant des informations claires et détaillées, même dans des contextes de code source ouvert, les développeurs contribuent de manière significative à la construction d'un écosystème d'IA digne de confiance et soutiennent le déploiement sûr et efficace de leurs contributions dans des applications à haut risque.

Tirer parti de l'exception scientifique: L'innovation sans perdre de vue la conformité

L'AIA prévoit des exemptions spécifiques pour les systèmes d'IA développés et utilisés exclusivement à des fins de recherche et de développement scientifiquesxvii , ce qui permet aux chercheurs d'innover sans avoir à supporter le fardeau immédiat d'une conformité totale à la réglementation. Cette exemption vise à respecter la liberté de la science et à soutenir l'innovationxviii , en permettant aux chercheurs des milieux universitaires, des institutions publiques de recherche ou des projets de recherche non commerciaux de développer de tels systèmes d'IA avec une plus grande flexibilité. Ce faisant, l'AIA favorise un environnement qui encourage l'expérimentation et le développement rapide de nouvelles applications de l'IA.

Cette exception est particulièrement importante pour les systèmes d'IA dans les phases de recherche scientifique du développement de dispositifs médicaux à haut risque, qu'il s'agisse de projets universitaires, financés par l'UE ou parrainés par le secteur privé. Toutefois, l'exception scientifique a des limites bien définies. Lorsqu'un système d'IA passe de la recherche scientifique au déploiement commercial ou réel, il doit se conformer à l'ensemble des exigences de l'AIA. Cela inclut les scénarios dans lesquels les résultats de la recherche sont intégrés dans des produits prêts à être commercialisés, offerts en tant que services ou déployés dans des flux de travail cliniques en dehors des environnements de recherche contrôlés. Même une évolution partielle vers la commercialisation, telle que l'élargissement de l'accès à l'outil au-delà des participants à la recherche ou son intégration dans des applications pratiques, rend l'exception scientifique inapplicable et soumet le système au cadre réglementaire de l’AIA.

Par conséquent, bien que l'exception scientifique offre un allégement réglementaire initial, l'objectif ultime de la plupart des projets de recherche est de voir les résultats se concrétiser dans des applications pratiques, commerciales ou cliniques. En anticipant les exigences réglementaires, même lorsqu'ils opèrent sous le couvert de l'exception scientifique, les chercheurs peuvent bénéficier d'avantages significatifs, notamment une meilleure préparation au marché et la capacité d'éviter les écueils qui pourraient entraver le succès de leurs systèmes d'IA.

Pour mieux se préparer à la conformité future, il est essentiel d'intégrer des stratégies clés dès la phase de recherche. Dès le départ, les développeurs doivent réfléchir à la manière dont leurs systèmes d'IA répondront aux exigences de l'AIA afin de minimiser les modifications futures. Le maintien d'une documentation technique complète tout au long de la phase de recherche facilitera la transition vers une utilisation commerciale en posant les bases des évaluations de conformité. En outre, un engagement précoce avec des experts juridiques peut clarifier les voies de conformité, ce qui permet d'éviter des modifications coûteuses, de réduire les retards et d'accélérer l'entrée sur le marché. Cette approche proactive garantit un cheminement plus fluide vers la commercialisation et l'alignement réglementaire.

Conclusion

Naviguer dans le cadre de conformité des dispositifs médicaux pilotés par l'IA en vertu de l'AIA implique de comprendre ses exigences complexes et de planifier stratégiquement. De la classification à haut risque au respect d'obligations de conformité rigoureuses, l'alignement sur ces exigences est la clé du succès. Voici quelques étapes clés pour guider votre approche :

▪ Identification et classification: déterminez si votre système peut être considéré comme un système d'IA au sens de l’AIA et sa classification des risques.

▪ Comprendre les exigences de conformité, et concevoir et documenter en gardant la conformité à l'esprit: Identifiez les exigences de conformité en fonction de la classification de votre système d'IA et intégrez ces considérations – telles que la gouvernance des données, la transparence, la surveillance humaine, l'exactitude et la documentation complète – dans les phases de conception et de développement.

▪ S'engager très tôt avec des experts juridiques: Consultez les experts juridiques dès le début pour clarifier les voies de conformité et rester informé de l'évolution des normes réglementaires. Cela garantit que votre approche s'aligne efficacement sur les cadres réglementaires actuels et futurs.

▪ Planifier la commercialisation: Que votre système d'IA soit développé dans un cadre de recherche ou dans des circonstances de développement normales, anticipez les besoins d'entrée sur le marché et intégrez les mesures de conformité dès le début afin de rationaliser les transitions. Cette anticipation minimise la nécessité d'une mise à niveau coûteuse, garantit la préparation du marché et renforce l'attrait du système pour les investisseurs, les régulateurs et les utilisateurs finaux, ouvrant ainsi la voie à une commercialisation réussie.

▪ Collaborer tout au long de la chaîne de valeur: Lors de la fourniture de systèmes, d'outils, de services, de composants ou de processus d'IA qui sont utilisés ou intégrés dans des systèmes d'IA à haut risque, évaluez la nécessité d'une collaboration avec les fournisseurs de systèmes afin de garantir l'alignement sur les obligations de conformité prévues à l'article 25, paragraphe 4. Il s'agit notamment de se préparer à partager les informations techniques et la documentation nécessaires à une intégration sans heurts.

En intégrant la conformité dès le départ, les parties prenantes peuvent libérer tout le potentiel des dispositifs médicaux pilotés par l'IA tout en adhérant aux normes de sécurité, d'éthique et de droit. Grâce à une stratégie proactive et complète, les organisations peuvent naviguer en toute confiance dans les exigences de l'AIA et mettre sur le marché des innovations transformatrices de manière efficace et responsable.

Nayana Murali, l'auteur de cet article, participe au projet financé par l'UE : AISym4MED. AISym4Med a reçu un financement de l'Union européenne dans le cadre du programme-cadre Horizon Europe, convention de subvention Nº : 101095387. Les points de vue et opinions exprimés sont toutefois ceux de l'auteur uniquement et ne reflètent pas ceux de l'Union européenne ou de la Commission européenne. Ni l'Union européenne ni l'Agence exécutive européenne pour la santé et le numérique ne peuvent en être tenues responsables.

Références:

i Règlement (UE) 2017/745 du Parlement européen et du Conseil du 5 avril 2017 relatif aux dispositifs médicaux, modifiant la directive 2001/83/CE, le règlement (CE) n° 178/2002 et le règlement (CE) n° 1223/2009 et abrogeant les directives 90/385/CEE et 93/42/CEE du Conseil (MDR). (Accès ici : https://eur-lex.europa.eu/legal-content/EN/TXT/?uri=celex%3A32017R0745)…;

ii Règlement (UE) 2017/746 du Parlement européen et du Conseil du 5 avril 2017 relatif aux dispositifs médicaux de diagnostic in vitro et abrogeant la directive 98/79/CE et la décision 2010/227/UE de la Commission (DMDIV). (Accéder ici : https://eur-lex.europa.eu/eli/reg/2017/746/oj)

iii Règlement (UE) 2024/1689 du Parlement européen et du Conseil du 13 juin 2024 établissant des règles harmonisées en matière d'intelligence artificielle et modifiant les règlements (CE) n° 300/2008, (UE) n° 167/2013, (UE) n° 168/2013, (UE) 2018/858, (UE) 2018/1139 et (UE) 2019/2144 et les directives 2014/90/UE, (UE) 2016/797 et (UE) 2020/1828 (AIA). (Accéder ici : https://eur-lex.europa.eu/eli/reg/2024/1689/oj)

iv Article 6, paragraphe 1, lu avec l'Annexe 1 de l’AIA

v Article 6, paragraphe 1, point b) de l’AIA

vi Décision d'exécution de la Commission relative à une demande de normalisation adressée au Comité européen de normalisation et au Comité européen de normalisation électrotechnique à l'appui de la politique de l'Union en matière d'intelligence artificielle. (Accès ici : https://ec.europa.eu/transparency/documents-register/detail?ref=C(2023)…;

vii Soler Garrido, J., Fano Yela, D., Panigutti, C., Junklewitz, H., Hamon, R., Evas, T., André, A. and Scalzo, S., Analysis of the preliminary AI standardisation work plan in support of the AI Act, EUR 31518 EN, Publications Office of the European Union, Luxembourg, 2023, ISBN 978-92-68-03924-3, doi:10.2760/5847, JRC132833. (Accessible ici : https://publications.jrc.ec.europa.eu/repository/handle/JRC132833)

viii Commission Implementing Decision of 22 May 2023 on a Standardisation Request to the European Committee for Standardisation and the European Committee for Electrotechnical Standardisation in Support of Union Policy on Artificial Intelligence, Art. 1 C(2023) 3215. (Accès ici : https://ec.europa.eu/transparency/documents-register/detail?ref=C(2023)…;

ix Article 40 de l’AIA

x Article 25(4) de l'AIA

xi Considérant 88 de l’AIA

xii Article 25(4) de l'AIA

xiii Article 25(4) de l'AIA

xiv Article 25(4) de l'AIA

xv Article 25(4) de l'AIA

xvi Considérant 89 de l’AIA

xvii Article 2(2) de l'AIA

xviii Considérant 25 de l’AIA